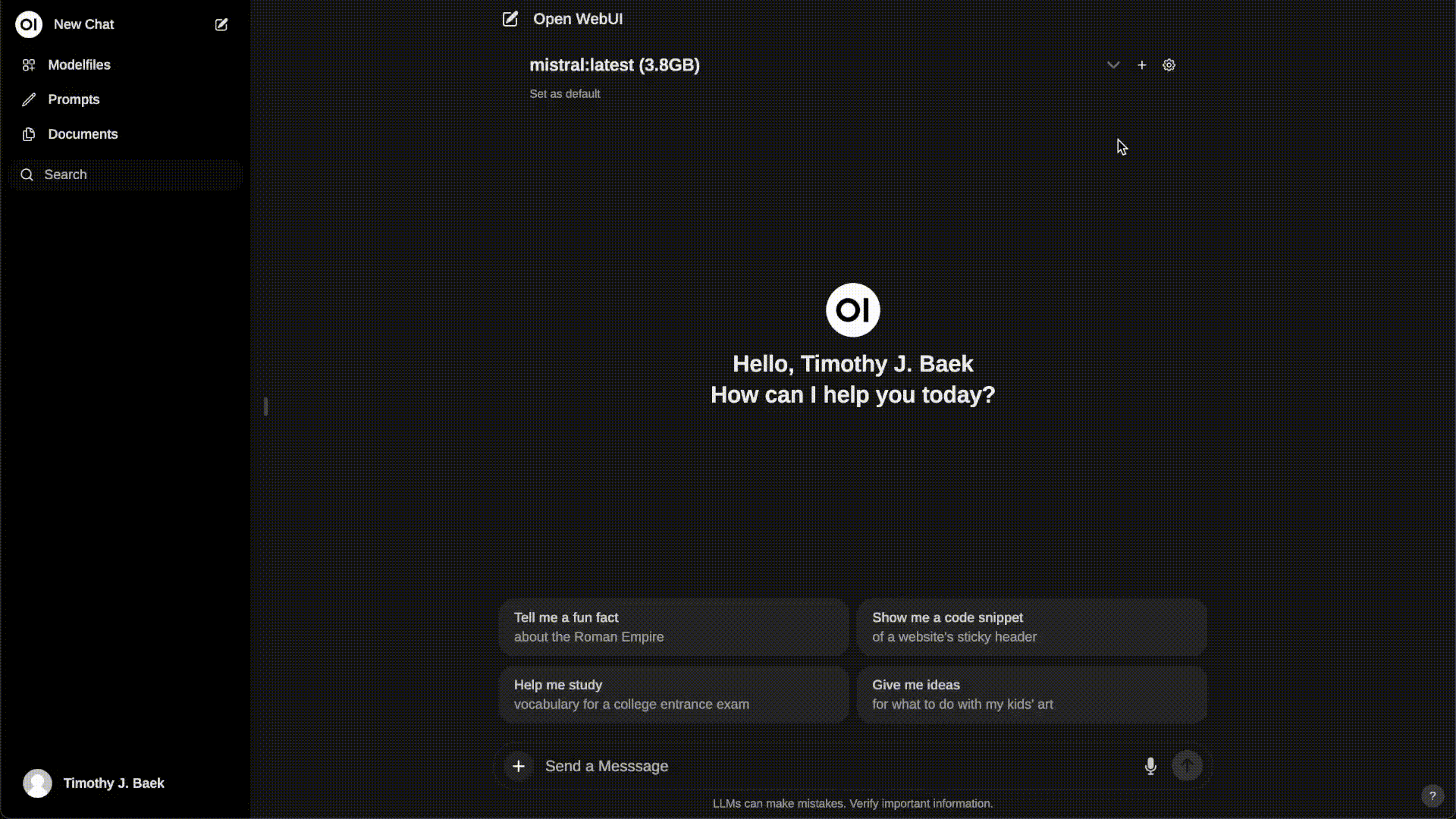

Open WebUI

Open WebUI 是一种可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线运行。它支持各种 LLM 运行器,包括 Ollama 和 OpenAI 兼容的 API。

这是一款优秀的GPT镜像网站

🌐 开源地址

如何安装

Docker

使用 Docker 安装 Open WebUI 时,请确保在 Docker 命令中包含 。此步骤至关重要,因为它可以确保您的数据库正确装入并防止任何数据丢失。-v open-webui:/app/backend/data

如果 Ollama 在您的计算机上,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main如果 Ollama 位于其他服务器上,请使用以下命令:

要连接到另一台服务器上的 Ollama,请将 更改为服务器的 URL:

OLLAMA_BASE_URLdocker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main安装完成后,您可以在 http://localhost:3000 访问 Open WebUI。享受!😄

打开 WebUI:服务器连接错误

如果您遇到连接问题,通常是由于 WebUI docker 容器无法访问容器内 127.0.0.1:11434 (host.docker.internal:11434) 的 Ollama 服务器。使用 docker 命令中的标志来解决此问题。请注意,端口从 3000 更改为 8080,从而产生链接:.--network=hosthttp://localhost:8080

Docker 命令示例:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main 评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果